从SIRI到无人驾驶汽车,人工智能(AI)正在迅速地发展。虽然科幻小说经常将AI描绘成具有类人特性的机器人,但AI可以涵盖从谷歌(Google)的搜索算法,IBM沃森 (人工智能程序),到自动武器的任何科技。

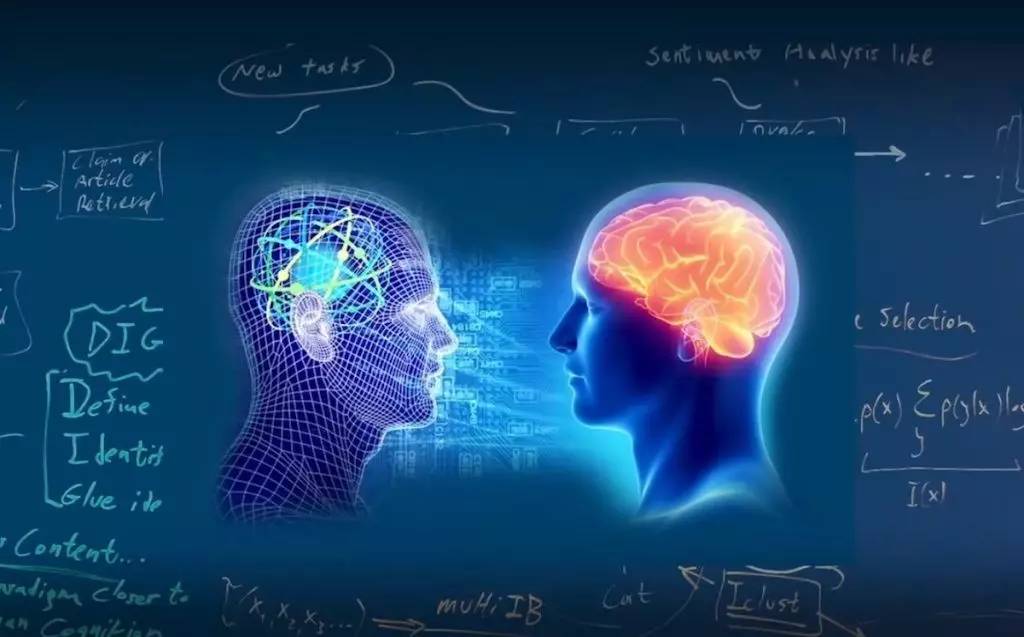

当今的人工智能被正确地称为窄AI(或弱AI),因为它被设计来执行的任务范围狭窄(例如,仅执行面部识别,或只进行互联网搜索,或仅驾驶汽车)。然而,许多研究人员的长期目标是创建普适AI(AGI或强AI)。虽然窄AI能在其特定的任务上超越人类,如下棋或解方程,AGI将在几乎所有认知任务上超越人类。

从长远来看,一个重要的问题是,如果我们成功创造了能在所有认知功能上超过人类的强AI,将会发生些什么。正如约翰·古德(Irving John Good)在1965年所说的,设计更有智慧的AI系统本身就是一个认知任务。这样的系统有潜力执行递归式的自我完善,触发智能爆炸,并远远地超越人类智力。通过发明革命性的新技术,这样的超级智慧能够在一定程度上帮助我们消除战争,疾病和贫困。

因此,创造强AI可能是人类历史上最重大的事件。然而,一些专家这样认为担心,人类的历史也会随着此类的超强大AI的诞生戛然而止,除非我们学会在AI成为超级智慧之前将使其与我们同心所向。

大多数研究人员同意,一个超智能AI不可能会产生人类的情感,如爱或恨。他们也认为人们没理由期望AI有意识地趋善向恶。当考虑AI如何成为风险时,专家觉得有以下情况最大有可能发生:

AI被设计执行毁灭性任务:自驱动武器(autonomous weapon)是为杀戮而生的AI系统。若落入恶人手中,这些武器很容易便可造成大量伤亡。此外,AI军备竞赛也可能无意中引发AI战争,导致大量伤亡。为了尽最大可能避免被敌对势力从中阻挠,这些武器的“关闭”程式将被设计得极为复杂,但人们也可能对这种情况失去控制。这种风险虽然也存在于窄AI(narrow AI)中,但随着AI智能和自驱动水平的提高,风险也会跟着增长。

以这些例子来看,我们对高级AI的担忧并非在于其可能会产生恶意,而是它可能达到的能力。人工智能安全研究的一个关键目的是要避免将人类置于和这些蚂蚁同样的位置。

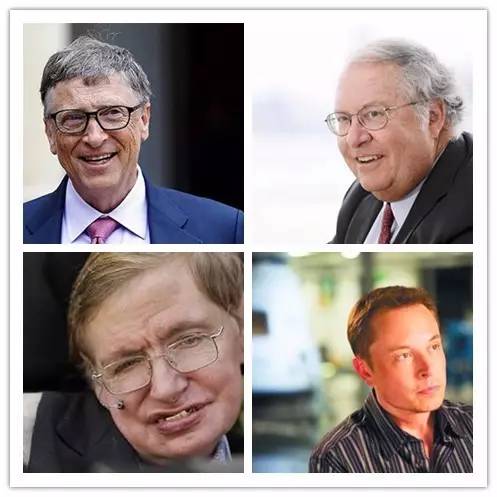

史蒂芬·霍金、伊隆·马斯克、史蒂夫·沃兹尼亚克、比尔·盖茨等许多科技大腕和许多领导AI研究的科学家最近在媒体和公开信中对AI风险表示关心。为什么这一个话题在近期会忽然出现在多则头条新闻中呢?

强AI的成功实现一直被认为是天方夜谭,即使得以达成也是最少是几千年以后的事情。然而,由于最近的突破性研究和许多AI里程碑的创造,在仅仅五年前被专家觉得是几十年后才可以做到的技术,现在已经实现。这让许多专家认真地考虑在我们整个人生中出现超级智能的可能性。虽然一些专家仍然猜测类人AI在几个世纪以后才有几率发生,大多数AI研究员在2015年波多黎各会议中预测类人级别的AI在2060年之前便可能会产生。因为AI安全研究可能耗费十几年才能完成,所以我们该乘现在便进行这样一些方面的研究。

由于AI有可能变得比人类更聪明,我们并没有确实的方式来预测它的行为将会是如何。对于AI的发展可能衍生出什么后果,咱们不可以把过去的技术发展作为参考,因为我们从来就没创造出任何能够在智慧上超越人类的科技。事实上,我们最能作为参考的依据便是人类本身的进化史。人类之所以能在今天成为这个星球的万物之灵,并不是因我们最强、最快或体积最大,而是因为我们是最具智慧的。如果有一天,我们不再是世上最聪明的,我们还能够自信对世界拥有控制力吗?返回搜狐,查看更加多

上一篇:新能源汽车十大名牌 下一篇:什么是人工智能